D2 の大橋です.フィラデルフィアで 2025年2月27日〜3月2日に開催された The 39th Annual AAAI Conference on Artificial Intelligence (AAAI-25) に参加し,発表を行いました.本記事では,AAAI 2025 の概要と自身の発表について紹介します.

基本情報

AAAI は,AI 分野におけるトップ国際会議の一つです.

今年は,ペンシルベニア州のフィラデルフィアにある Pennsylvania Convention Center で開催されました.

今年の投稿数は,12,957 件(前年 +3,095 件 )で,このうち 3,032 件(23.4%)が採択されました.発表件数が多く,会場は非常に賑わっていました.

基調講演

AAAI 2025 では計5件の講演がありました.ここでは,自分が聴講した3つの講演について紹介します.

- Susan Athey

Predicting Career Transitions and Estimating Wage Disparities Using Foundation Models

労働経済学の問題,特に労働者のキャリアに関連する問題に対する,基盤モデルを用いた取り組みの紹介でした.例えば,大規模な履歴書のコーパスを用いて LLM を構築した研究が紹介されましたが,そのモデルを,男女賃金格差の原因の説明にも活用していて,画期的だと感じました.

- Andrew Ng

AI, Agents and Applications

LLMエージェントを活用したアプリケーション開発に関する講演であり,エージェントの強力なコーディング能力や汎用的な能力によって,アイデアからプロトタイプ実装までが従来よりも大幅に迅速化されることが説明されました.Andrew さんは,これが全ての人にとって,大きな(big)かつ刺激的な(exciting)機会であると強調していました.

- David Chalmers

Propositional Interpretability in Humans and AI Systems

AI システムの解釈可能性に対する哲学的なアプローチに関する講演で,特に,人間の行動を理解する哲学的手法である「命題的態度」を活用することの重要性が説明されました.講演を聞いて,最近人気のある SAE や CoT だけでなく,哲学的な観点からの解釈も興味深いと思いました.

自身の発表

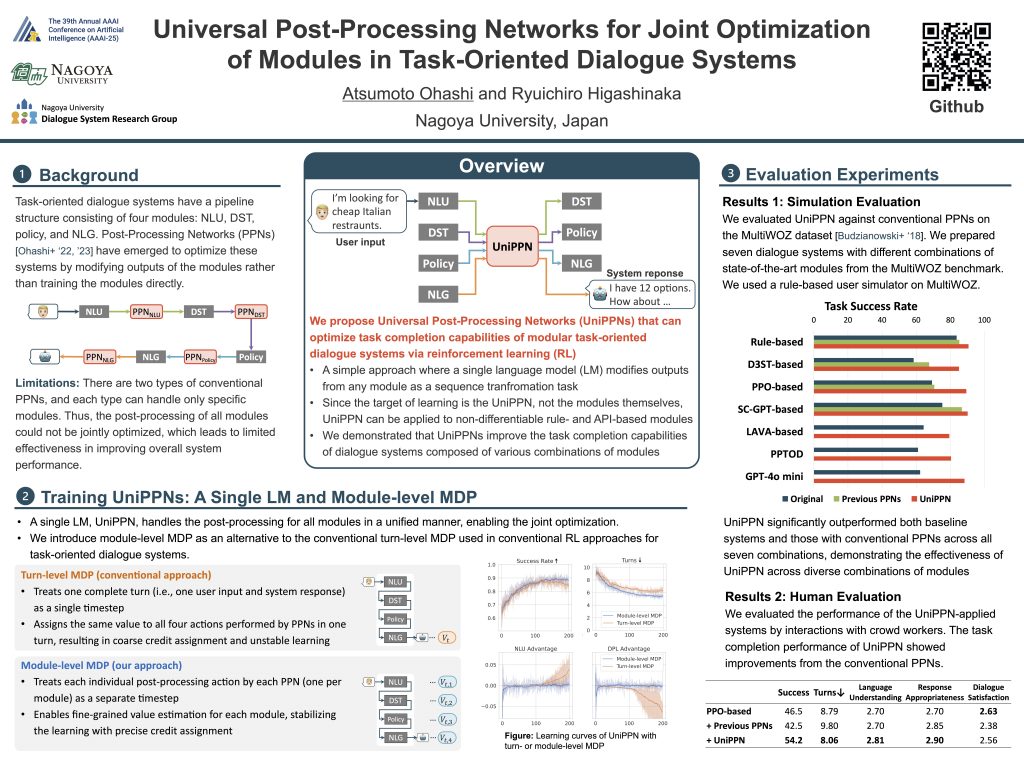

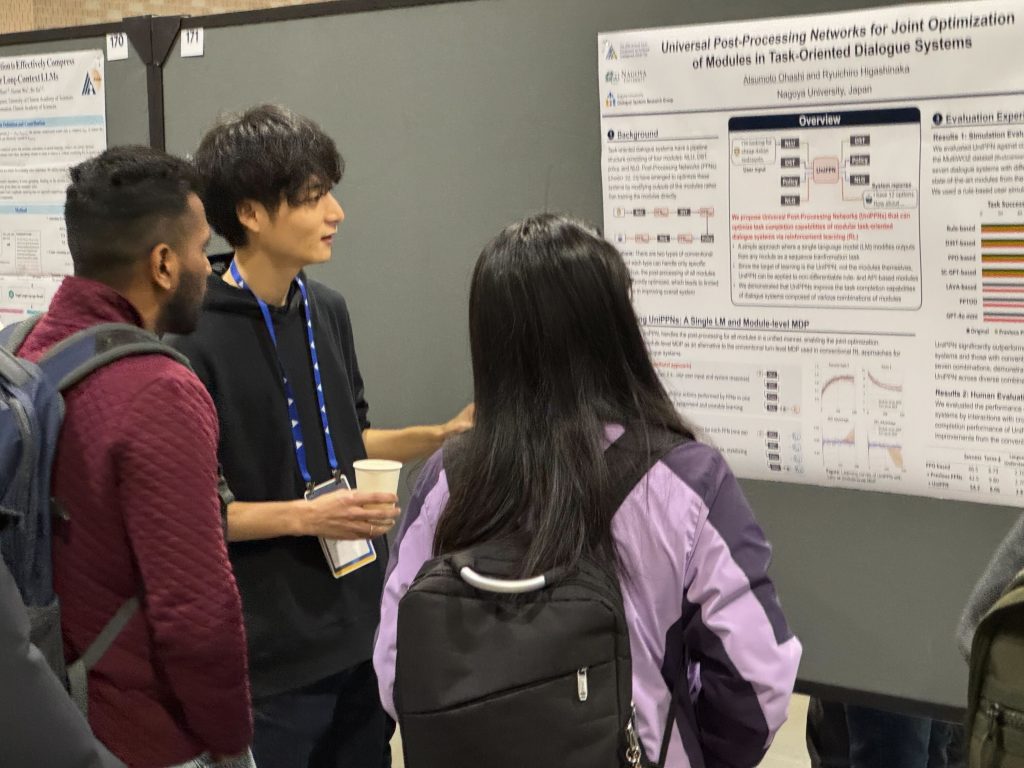

私は,3日目のポスターセッションにて,タスク指向型対話システムに含まれる様々なモジュールを統一的に改善するためのコンポーネント Universal Post-Processing Network (UniPPN) を強化学習によって最適化する研究について紹介しました.

Universal Post-Processing Networks for Joint Optimization of Modules in Task-Oriented Dialogue Systems Proceedings Article

In: Proceedings of the Thirty-Ninth AAAI Conference on Artificial Intelligence (AAAI-25), 2025.

気になった発表

ここで,自分が気になった研究のうち,対話システム研究に使えそうだと思ったものをいくつか紹介します.

- Ziyang Ma, Yakun Song, Chenpeng Du, Jian Cong, Zhuo Chen, Yuping Wang, Yuxuan Wang, Xie Chen

Language Model Can Listen While Speaking

Full-duplex な音声対話モデルの実現に向け,聴きながら(Listen)話す(Speaking)ことができる音声言語モデル LSLMを提案した研究です.モデルが発話している間も,ユーザ音声を常に入力することで,ユーザの介入に対応できます.まだTTSタスクにしか適応できませんが,これから重要な技術になってくると思いました.

- Jiayi Zhou, Jiaming Ji, Juntao Dai, Yaodong Yang

Sequence to Sequence Reward Modeling: Improving RLHF by Language Feedback

強化学習を用いた LLM のアライメントにおいて,発話に対する報酬を,トークン単位で精緻にモデル化する研究です.Seq-to-seq なモデリングによる報酬計算のアイデアが面白く,従来の一般的なスカラー値での報酬モデルを用いた場合よりも性能が改善している点でも有用だと感じました.

- Raghav Gupta, Ryan Sullivan, Yunxuan Li, Samrat Phatale, Abhinav Rastogi

Robust Multi-Objective Preference Alignment with Online DPO

Online DPO を活用して,LLM を複数の目的関数に対して最適化できるアライメントアルゴリズム MO-ODPO を提案した研究です.目的関数ごとの重み(重要度)を用いて LLM を条件付けすることで,推論時に LLM の応答スタイルを制御できる点が有用だと思いました.

おわりに

発表件数の多い AAAI ですが,やはり分野の種類も非常に多岐に渡り,主に NLP 系の会議しか参加した経験のない自分としては,規模の大きさに圧倒されました.特に,多様な分野の人たちがポスター会場で混雑している雰囲気は,新鮮で楽しかったです.また, CV や ML 系が多かった一方で,対話系の研究は少なく,若干の寂しさもありました.

開催場所はフィラデルフィアということで,名物のチーズステーキも何度か食べてみました.お店によっておいしさは変わりますが,ボリュームは一貫して多く,さすがアメリカという感じでした.

また,少しだけニューヨーク観光をする時間があって(Amtrak という鉄道でフィラデルフィアからは2時間弱),自由の女神やタイムズスクエアに行けたのがよい思い出になりました.